人工知能ツール開発のリーディングカンパニーであるRunwayは、この冬に開催された第1回AI映画祭の受賞作品を紹介した。何百もの応募作品の中から、審査員が10人のファイナリストを選び、その作品を公開した。このコンペティションの主な目的は、”AI映画製作の最前線で不可能を可能にする芸術とアーティスト “を称えることだった。私たちは興味津々で、AIが生成したアートから3Dシーンの全体スキャンまで、さまざまな技術が受賞作品にどのように統合されているのかを分析した。どんなクリエイターでも利用できるようになった、新しい技術の素晴らしさを紹介する。

1分~10分程度の動画で、当然ながらニューラルネットワークが使われていることが、映画祭の大きな基準のひとつだった。どのAIを使うか、どのように作品に登場させるか、といった厳密な定義はなく、受賞作品には実にさまざまなツールが使われている。最先端技術の使用は、作品の成功の25%に過ぎず、審査員は作品全体の構成やオリジナリティ、そしてもちろん芸術的メッセージも考慮されている。

AI映像制作の一環としてアートジェネレーターを活用する

私が最も感銘を受けた短編のひとつが、Laen Sanchesの「PLSTC」だ(以下、動画を埋め込む)。基本的には、何百枚もの写真を高速編集したもので、プラスチックに包まれて逃げられないさまざまな海洋生物を描いている。監督は、AIアートジェネレーターのMidjourney(こちらで紹介)が作成した強力な画像を、AIツールのTopaz Labsの助けを借りてアップスケールし、わずかにアニメーションをつけている。このように、マッチするビジュアルを的確に選択することで、非常に明確でまとまりのある映画の雰囲気を実現している。一言も発しないが、メッセージは明確であり、それは痛々しい。ドラマチックなクラシック音楽も深い感情を呼び起こすのに役立ち、その結果、小さな物語のような不思議な作品に仕上がった。どの賞にも入らなかったが、間違いなく見る価値のある作品だ。

映像のアイデアも、最終的な仕上がりの美学も気に入っている。しかし、重要なことだが、少なくとも今のところ、映画を作るときにこの方向で行くべきでないと思う。AIが生成したアートを実際のプロジェクトで使用することについては、さまざまな議論がある。MidjourneyやStable Diffusionのようなツールの開発者は、誰が権利を持っているかに関係なく、ありとあらゆるコンテンツに対してニューラルネットワークを訓練していることを意識しておく必要がある。従って、出力されたものを自分の作品だと主張することは、帰属や対価を受け取らないオリジナルのアーティストに対して倫理的でも公正でもない。私見だが、それらのAIツールをリサーチやムードボード、あるいは一般的にアイデア開発の段階で使うのは問題ないだろう。

とはいえ、希望はある。先週、Adobeはまさにこの問題に取り組むために設計した「Firefly」を発表した。このAIアートジェネレーターは、合法的で包括的なデータセットのみを使用することを約束している。例えば、開発者はFireflyのディープラーニングモデルを、Adobe Stockの画像、オープンライセンスの映像、著作権が切れたパブリックドメインのコンテンツでトレーニングした。しかし、まだ改善の余地はある。一部の映画制作者は、Adobeに対して、Stockクリエイターが自分の映像をどのように使用するか、また使用する場合はその補償も含めて選択できるようにするよう求めている。

私はそれが次のステップだと考えているが、このソフトはまだ非常に新しい。まだ一般利用は出来ないが、誰でもここで興味を示してベータアクセスに登録することができる。

実際のシーンを3Dスキャンで再現 – AIによる映像制作を別視点から考える

もうひとつ、この映画祭で興味を引いたのは、銀賞を受賞したジェイク・オレソン監督の「Given Again」だ。彼の作品は、時間が止まったような、夢のような思い出のような日常的なシーンの中を、観客を美しい旅へといざなう。雰囲気があり、芸術的で、魔法にかかったような、従来のストーリーテリングとは一線を画す作品だ。そして、最も印象的なのは、すべてのシークエンスがLuma AIのNeRFテクノロジーを使って作成されていること。まずはご覧いただき、その後、技術的な詳細について説明する。

Luma AIは、iPhone(11以降)を使うだけで、フォトリアリスティックで高品質な3Dモデルを作成することができる。このアプリでは、物体や風景、またはシーン全体(上のビデオの例のように)を簡単にキャプチャし、それを詳細な3D環境に変えることができる。このスキャンの最も興味深い点は、いわゆるNeRF技術(「Neural Radiance Fields」の略)に基づいていることだ。簡単に言うと、ディープニューラルネットワークを使って、さまざまな角度から撮影した画像や動画を分析することで、対象物の根本的な3D構造を学習する。そして、3D空間の各ポイントの色や見え方を予測し、高品質で非常に詳細なモデルを合成することができるのだ。

3Dスキャンを作成した後は、その瞬間を再現するだけでなく、ポストプロダクションで不可能なカメラの動きを試すことができる。”Given Again “は、このAI技術が、たとえ低予算でも映画制作を向上させる可能性があることを示す、エキサイティングな例といえるだろう。

AIを使ったエフェクトをあなたの映像に

Runway’s AI film festivalのグランプリは、Riccardo Fusettiの「Generation」という作品に決定した。この作品は、現代的なパフォーマンスと重厚な視覚効果、哲学的なナレーションテキストを組み合わせた、非常に表現豊かで抽象的な作品だ。

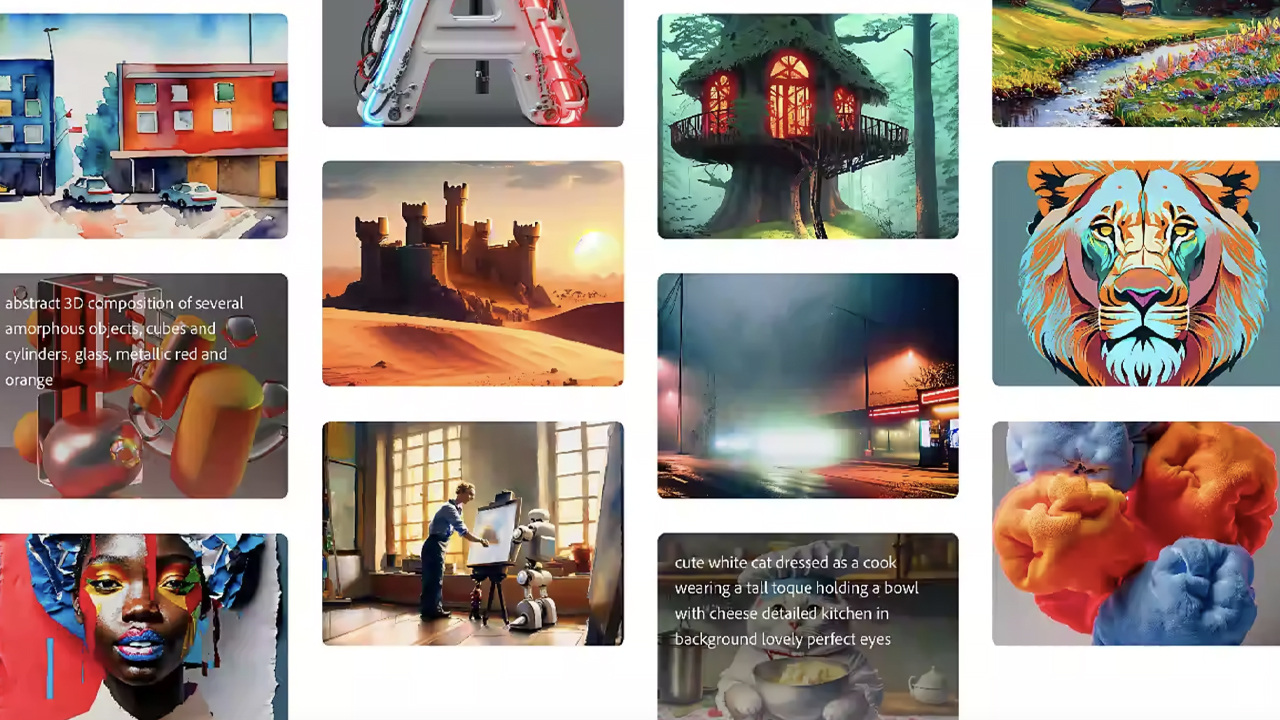

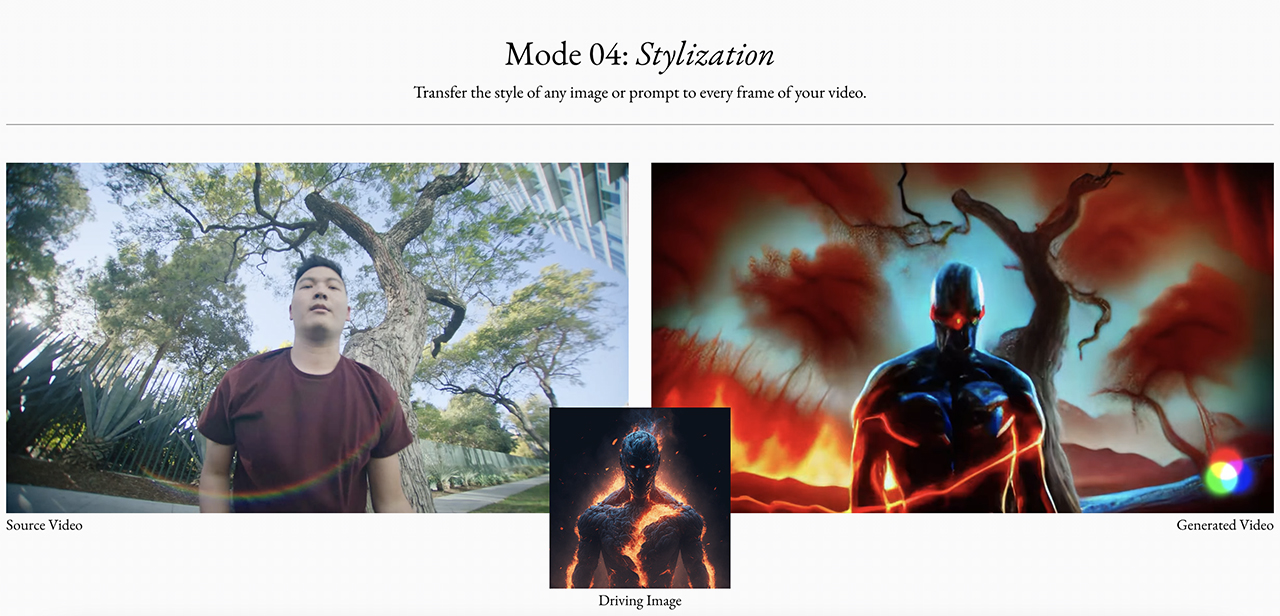

リカルドがこのプロジェクトで使用したAI技術を100%把握しているわけでは無いが、例えばRunwayのGen-1で同様の結果を得ることは可能だ。かなり長いベータテスト期間を経て、ようやく一般公開さ れた。登録後、ユーザーは制限された量のクレジットを使って、この技術を無料で試すことができるようになった。

Gen-1の最初のアイデアは、参照画像やテキストプロンプトを使用して既存のビデオから新しいビデオを生成することで、クリップに特定のスタイルを適用することが可能。シンプルな形(靴箱など)を複雑なオブジェクト(高層ビルなど)に変えたり、マスクされたオブジェクトだけを調整したりすることができる。

しかし、これはほんの始まりに過ぎない。現在、AIを使ってテキストから映画全体を作成する実験を行っている様々な研究プロジェクトがある。例えば、Googleの人工知能開発については、私たちも記事にした。Runway も最近、新製品 Gen-2 を発表し、ゼロから動画を作ることができる。ワクワクするような、恐ろしいような、まったく新しい世界が、すぐそこに待っているの だ。

AIツールで映画製作を民主化する

映画祭のページには、他にもたくさんのAI映画制作の事例が掲載されている。また、このテーマに関する著名なアーティストの意見に興味がある場合は、Darren Aronofskyなどの参加者によるパネルディスカッションを見ることができる。

主な議論は、人工知能が非常に若く、急速に進化している分野であるという事実に関するもので、我々はそれに対して正しいアプローチを取らなければならない。倫理的に使用することが重要であり、仕事を奪うものではなく、クリエイティブなアシスタントとしてとらえることが大切だ。同時に、AIが映画制作の民主化に貢献することは、誰もが認めるところだ。新しいテクノロジーは、これまでインディペンデントなクリエイターや低予算のプロダクションが利用できなかったツールを提供する。

これは重要なポイントだと思うし、AI映画祭はそれを裏付けている。ファイナリストの中には、A$AP Rockyの曲「Shittin’ Me」(YouTubeで現在650万回再生)の公式ミュージックビデオや、Sam Lawtonによる小さな個人作品「Expanded Childhood」(自身のアーカイブ写真を使って幻想的なAI拡張環境を作成する)も含まれている。

映画制作の未来

最終選考に残った短編説明ビデオ「Checkpoint」は、AIの暗示に対する一般的な反応を、1830年代に写真が発明されたときに画家たちが猛烈な抗議をしたことになぞらえている。しかし、時が経つにつれ、彼らは近代的なツールを評価するようになり、さらには新しい芸術の形として、その目的や意味を再定義するようになった(もう写実的である必要はないのだ)。

Feature image: a film still from “Generation” by Riccardo Fusetti. Image credit: Runway.