あちらにもAI、こちらにもAI…今や映像制作のあらゆる段階で、少なくとも1つは便利な人工知能ツールを見つけることができる。創造性を高めたり、ありふれた作業を代行したり、基本的なワークフローをスピードアップしたり。現代のテクノロジーに何ができるのか、いつも驚かされる。メタ社の新しいAIを搭載した音楽ジェネレーターMusicGenは、ほんの数週間前に一般公開されたばかりだが、レビュアーたちはすでに、その計り知れない可能性を実感している。このツールを使えば、簡単なテキスト記述から高品質でロイヤリティフリーの音楽を作成し、プロジェクトで直接使用することができる。

最近、(UppbeatやArtlistのような)ストックフッテージ・プラットフォームが改善され、人工知能を使ってユーザーがプロジェクトに最適なクリップを見つけられるようになったという話をした。しかし、非常に具体的な音楽のリクエストがあり、プロの作曲家を雇うのは残念ながら予算が足りない場合、MusicGen by Metaは、すぐに解決策を提供するかもしれない。すでにGoogleのMusicLMよりも有望に見える。

MetaによるMusicGenとその競合

まず第一に、Googleとは異なり、Metaは同社の音楽生成モデルをオープンソースプロジェクトとして立ち上げることにした。興味のある人は、テストするだけでなく、開発に貢献し、最初のニューラルネットワークをベースに独自のバリエーションを作ることができる。

MetaのMusicGen研究者エンジニアの一人、フェリックス・クルック(Felix Kreuk)が投稿した上の紹介ビデオで見聞きできるように、この新しいAIは、テキストプロンプトと楽曲の両方をメロディー作成の出発点として使うことができる。これは、以前の競合するジェネレイティブ・ソフトウェアに欠けていた新しいものでもある。

これに加えて、研究論文では、Metaは彼らの音楽ジェネレーターで作成されたクリップを、GoogleのMusicLM、Riffusion、Moûsaiで作成された例と比較した。その結果、”MusicGenは、人間のリスナーによって評価された評価ベースラインよりも、音質と提供されたテキスト記述への忠実さの両方において優れている “ことが示唆された。これは、MusicLMがMusicGenに比べて10倍の量のデータトラックで学習されたことを考えると、さらに印象的だ。

仕組みは?

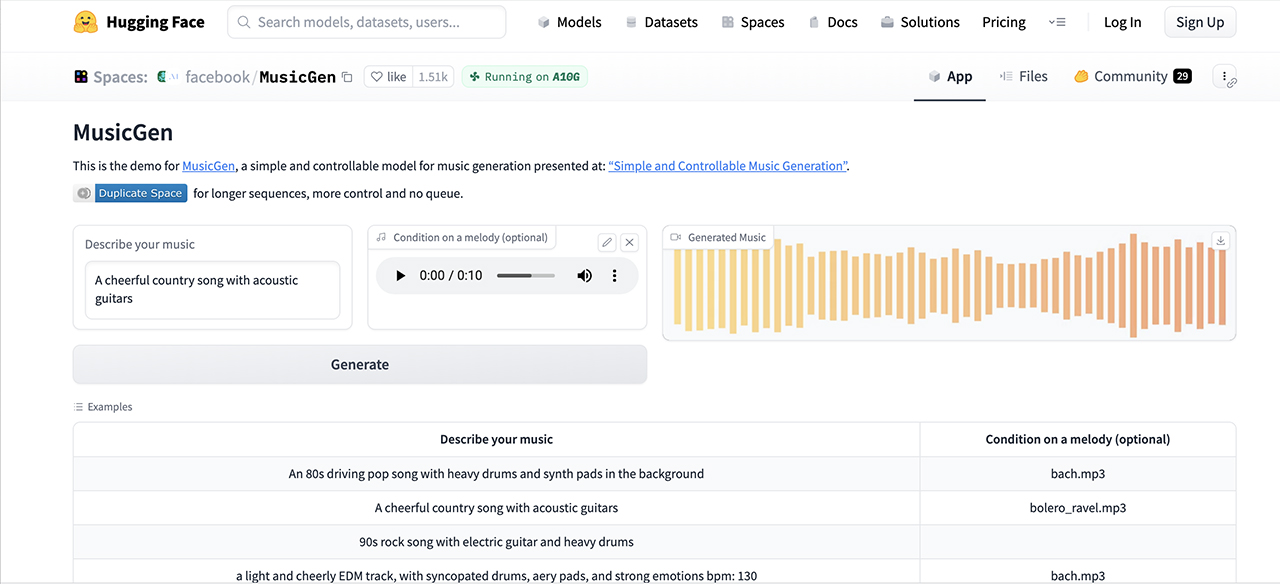

外から見れば、非常にシンプルだ。(機械学習がどのように機能するかという複雑な世界に飛び込むのはやめておこう。) ニューラル・ネットワークに基本的なテキストの説明(「アコースティック・ギターが入った陽気なカントリー・ソング」といったようなもの)を与え、(必要であれば)追加のリファレンス・トラックを送り、「generate」をクリックする。ほんの数秒後、MusicGenはテキストと音楽的な合図に基づいて15秒間のオーディオを生成する。ソースミュージックをアップロードすると、このモデルはその幅広いメロディーを結果のクリップに組み込もうとする。だから、あなたのクリエイティブなYouTubeビデオに「フレンズ」のイントロをダークメタル風にひねったようなものを使っても問題ない。

ちなみに、プロンプトはもっと具体的に設定できる。例えば、MusicGenは指定された1分間の拍数(bpm)を絶対に正確に刻むが、これはループの作成には重要かもしれない。映画のサウンドトラックの領域では、たった15秒の生成されたオーディオでも、素晴らしい効果を発揮する。同時に、このプロジェクトのHugging Faceスペースにサインアップしたユーザーは、最大120秒のクリップにアクセスできるようになる。

倫理的な問題

新しい音楽ジェネレーターで遊ぶのは楽しいが、倫理的な話題についても考えてみよう。ジェネレーティブAIがクリエイターのコミュニティに与える影響は周知の事実で、広範な議論や討論を巻き起こしている。ほとんどの場合、開発者はモデルを訓練するために利用可能なあらゆる映像を使用し、権利や帰属を気にしない。Metaは違う方法をとった。同社によると、MusicGenは10,000時間に及ぶ「高品質な」公認楽曲と390,000曲のインストゥルメンタル・トラックを使った。(映像は主にShutterstockやPond5のようなメディアライブラリから入手した)。 さらに研究者によると、このデータセットは権利者との法的合意によってカバーされており、プロジェクト全体はMITライセンスの下でライセンスされている。

上で紹介した研究論文の中で、MetaはAIが生成する音楽の倫理についても触れている。彼らはそれを取り巻く懸念を、オープンソースのアプローチの理由のひとつと呼んでいる。こうすることで、MusicGenはすべてのプレイヤーが平等にモデルにアクセスできるようにしている。開発者は、アーティストのために不公平な競争を作りたくないと書いている。

私たちが紹介したメロディ・コンディショニングのような、より高度なコントロールの開発を通じて、このようなモデルが音楽のアマチュアとプロの両方にとって有用なものになることを願っています。

A quote from the research paper

音楽ループとそれを避けるべき時

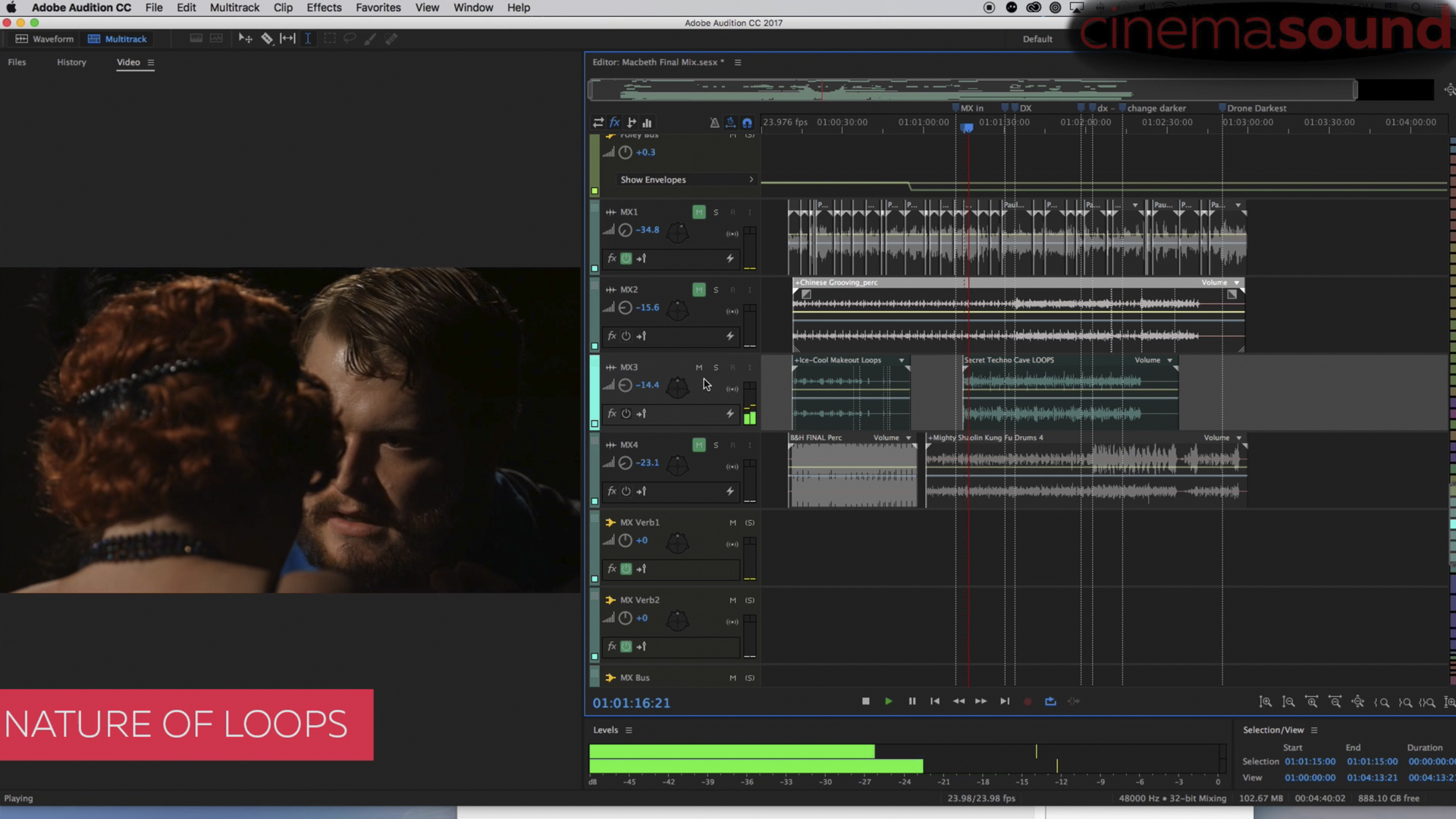

Meta社がMusicGenを発表したことで、短いオーディオクリップの作成が簡単になったようだ。誰もがメロディーを想像し、いくつかの言葉を書き、”generate “をクリックすれば、例えばループのための強固なベースを得ることができるようになった。しかし、サウンドトラックでループをいつ、どのように使うかは簡単な問題ではなく、使いこなす必要がある。MZedのコース “Cinema Sound “では、オーディオの第一人者であるマーク・エドワード・ルイスが、正しい音楽の選び方についてのみ、数時間のレッスンを行っている。彼はさらに、ループを使うべき理由と避けるべき理由を掘り下げており、私がここから得た最も重要な教訓は、メロディーの選択と配置を誤ると、俳優の演技を完全に台無しにしてしまうということだ。

上のスクリーン版「マクベス」のシーンを例にとってみよう。デモの間中、マークは様々な音楽ループを伴っているが、残念なことに、結果はすべてひどいものになっている。しかし、なぜだろう?ループには感情の起伏を滑らかにする強力な能力があるからだ。ループは視聴者に時間の圧縮とわずかなサスペンスを感じさせる傾向がある。ひねりを待っているような、何かが起こるのを待っているような、そんな音楽要素が繰り返される。これは、セリフのない静かなアクションシーンを強調したり、非ダイナミックな瞬間に緊張感をもたらしたり、あるいはシーンにコメディタッチを与えたりする必要があるときに便利なツールになる。しかし、ドラマチックな場面では、ループは俳優の演技を潰し、シーンの感情的な弧を平坦にしてしまうので、絶対に禁物だ。

これは、ビデオプロジェクトで新しいループを生成する際に考慮すべき重要なヒントだ。もっと詳しく知りたい方は、85時間以上に及ぶ専門家の魅力的なトピックからなる “Cinema Sound “コースをご覧ください。

MusicGen by Metaを実際に試してみる

すでに述べたように、MusicGen by Metaは現在一般公開されている。Hugging Faceプラットフォームのテキスト記述から独自のミュージッククリップをブラウザで直接生成してみることができる。また、モデルのコードをダウンロードして手動で実行することも可能だ。

Full disclosure: MZed is owned by CineD.

Feature image source: created with Midjourney for CineD.